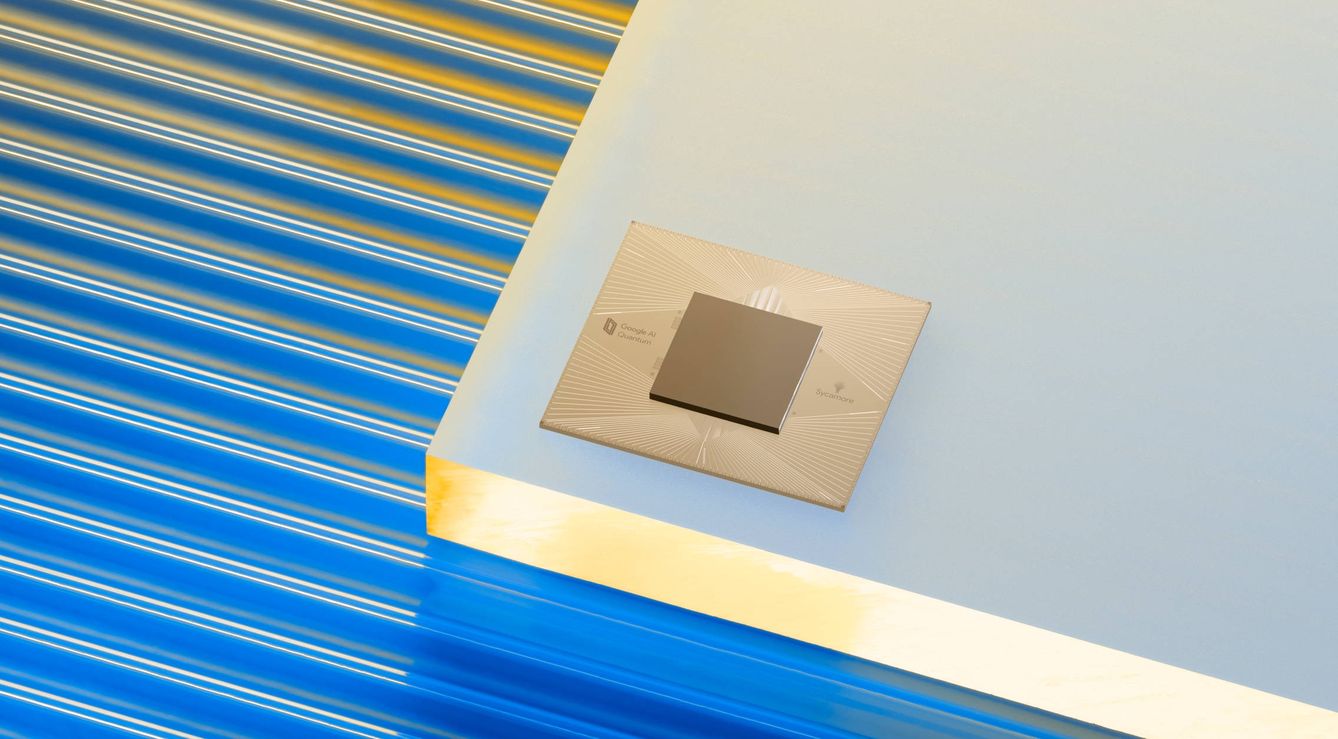

Foto: Google.

Llevamos décadas hablando de esta tecnología y empresas como esta o IBM prometen estar más cerca que nunca de hacerla funcional. Sin embargo, ¿por qué aún no tenemos claro qué problema soluciona?

Esta semana Google dio detalles en su conferencia de desarrolladores de uno de los ordenadores que anda preparando. Una máquina capaz de resolver en poco tiempo un supuesto entuerto matemático que a tu PC le podría llevar billones —sí, con 'b'— de años. Incluso un equipo de muchos quilates como el superordenador español 'Marenostrum' sudaría tanto llevando a cabo el eventual encargo que no merecería la pena usarlo para este fin. Pero este prodigioso aparato no entrará en tu mochila, ni en tu casa, ni en el despacho de tu oficina porque se trata de un ordenador cuántico, una de las hipotéticas revoluciones que más ha dado que hablar en las últimas décadas, primero en los círculos académicos y, posteriormente, en los empresariales, una vez las 'big tech' se han interesado por ella.

Pero durante muchos años ha sido una de esas promesas vaporosas en las que tanto suele caer este gremio, algo más parecido a un brindis al sol donde algunos no veían nada más que humo por falta de avances concretos, cosas palpables más allá de las formulaciones teóricas. Pero ahora todo parece haber cambiado. Hay al menos un horizonte temporal sobre la mesa, ya que la multinacional estadounidense ha puesto fecha a su primer modelo comercial: 2029. Ese será el momento para que este invento ponga su orgásmico rendimiento al servicio de empresas e instituciones de todo el mundo.

"Esto representa un cambio fundamental, porque esta tecnología aprovecha las propiedades de la mecánica cuántica y nos brinda una oportunidad para comprender el mundo natural", enunció Sundar Pichai, CEO de la compañía, antes de anunciar una inversión millonaria con la que se cumplirá la mencionada hoja de ruta. Además, han abierto su propio cuartel general 'cuántico': un campus en Santa Bárbara (California) compuesto de varios edificios, donde además de las instalaciones para albergar la computadora en cuestión también habrá laboratorios, talleres para dar formas a diferentes a chips y componentes y otras tantas estancias.

La informática del cero absoluto

Es probable que la palabra 'ordenador comercial' pueda llevar a equívoco. No habrá una torre que puedas comprar en una tienda o pedirle a tu proveedor. A este se accederá remotamente, a través de la nube. Es cierto que la electrónica está inmersa en una paulatina transición de digitalización del 'hardware'. El mejor ejemplo de esto son las consolas, donde se espera que la PS5 y la Xbox Series X sean la última generación que requerirá eso de tener una máquina física en casa. Sin embargo, en el caso de las computadoras cuánticas esto es algo obligado.

La razón es el llamado condensado de Bosé-Einstein. Es una técnica mediante la cual se utiliza un láser para enfriar una nube de gas hasta el cero absoluto (-273 grados centígrados), momento en el que la materia adquiere propiedades cuánticas. Mantener ese entorno controlado es crucial para que no se produzca la llamada como 'decoherencia cuántica' que, 'grosso modo' y sin entrar en demasiados vericuetos técnicos, no es otra cosa que deje de tener esas 'supercaracterísticas' y acabe con un desarrollo costosísimo que ofrezca lo mismo un ordenador mundano. Por esta razón, lo habitual el día de mañana es que a estos servicios se acceda a través de la nube y se mantengan en ubicaciones controladas al milímetro.

Foto del campus de Santa Bárbara. (Google)

Si la informática habla cargada de bits, la informática cuántica lo hace con cúbits. El nombre no tiene mucho más misterio que el de conjugar la palabra 'bit' y 'cuántico'. Estos cúbits tienen dos grandes particularidades frente a los bits de toda la vida. La primera de ellas es la superposición. Si el bit, la unidad mínima de información, puede tener un valor de 0 o 1, su 'sucesor' puede tener ambos valores al mismo tiempo. Es difícil encontrar un símil que haga más digerible la idea, porque el funcionamiento escapa a comparativas con cosas o procesos de nuestro entorno. ¿Se imaginan una bombilla que pueda dar luz y estar apagada al mismo tiempo? Pues eso. "La informática clásica trabaja, por así decirlo, con procesos en paralelo. Aquí se superponen, se ejecutan a la vez uno encima del otro y sin perder potencia de computación", comenta Patricia Contreras Tejada, investigadora en el Instituto de Ciencias Matemáticas del CSIC, en un intento por resumir esa ventaja competitiva.

Pero, además de ese particular sistema para gestionar la información, hay otro fenómeno clave que hay que tener en mente: el entrelazamiento. Estos cúbits se pueden comunicar sin que haya ningún circuito de transmisión. Y no, no importa la distancia. Si están entrelazados pueden estar a dos centímetros o a 2.000 años luz, que da exactamente igual. Aquellos que están conectados, automáticamente condicionan la naturaleza del otro. Es decir, es la misma.

Estos son dos pilares básicos que explican las tripas de esta tecnología y por qué va a ser capaz de manejar un volumen de datos y operaciones mucho mayor. A Contreras Tejada le gusta utilizar un ejemplo visual: el de la ilusión óptica compuesta por dos caras que se miran que viéndolas en conjunto forman una copa. Pueden ser cara y copa al mismo tiempo y cuando las caras se entrelazan visualmente dan ese nuevo resultado.

Los cúbits tienen la piel fina

El problema viene porque estos cúbits tienen la piel muy fina. "Las cosas pequeñas no se comportan como las grandes. Tienen muchas particularidades". Mantener las condiciones del entrelazamiento y otros aspectos del estado cuántico es tremendamente complicado y costoso.

"Es algo muy frágil. Le puede afectar un mínimo cambio de temperatura, la fluctuación de los campos magnéticos, emisión radiactiva, ruido que se produce por los materiales superconductores que se han utilizado para construir las máquinas... Cualquiera de esas cosas puede producir la 'decoherencia'. Estamos hablando de que esto ahora solo se ha conseguido evitar durante microsegundos", explica Diego Porras, investigador del Instituto de Física Fundamental del CSIC.

Una de las vías de investigación que más se está trabajando para mantener ese estado cuántico más tiempo es la de aumentar el número de cúbits. Hacerlo hasta un nivel en el que, cuando uno falle, el resto sean capaces de compensarlo. Google tiene en el camino varias metas volantes, pero al final de su plan de viaje aparece la cifra de un millón de cúbits. Probablemente le diga poco. Pero, si se les dice que los mejores ordenadores cuánticos del momento se manejan en torno al centenar de cúbits, la historia cambia. IBM, el otro gran competidor de Google en esta carrera, pretende poner en circulación este año el procesador Águila, que tendrá 127 de estos sistemas. Estos números dan idea del salto cualitativo que pretende dar la compañía de Sundar Pichai, que en caso de cumplir sus planes se adelantaría un año a la fecha que dio IBM, 2030, para alcanzar estos guarismos.

"Es un punto de inflexión", comentó el martes el doctor Hartmut Neven, el científico que lleva desde 2006 supervisando el trabajo de Google en este campo. "Ahora tenemos los componentes que nos dan confianza para lograrlo".

El ordenador cuántico de IBM. (Reuters)

Conseguir que una máquina que funcione con un millón de estas 'partículas' permitiría a la compañía tener un sistema a prueba de fallos y, por tanto, poder ofrecer una fiabilidad comercial mucho mayor. "No es que no se van a producir errores. En todos los ordenadores, hasta en los clásicos, ocurren. Lo que pasa es que con esas cifras se puede hacer compensación de errores y reducir el ruido en los resultados o que se interrumpa el cálculo", explica Diego Porras. Añade este experto que hay que pensar en ese millón de cúbits como una suerte de supercúbit o 'cúbit lógico' que actúa coordinado. "Si falla alguno, existiría tal redundancia que son capaces de 'eliminar' ese fallo".

Porras define el plan de Google como "muy ambicioso". Esta compañía e IBM parecen ser las que se han puesto al frente de un pelotón que cuenta con insignes miembros como Microsoft, Intel o Honeywell, que han invertido miles de millones de dólares en el último lustro para acelerar esta tecnología. "Ha sido clave que estas grandes tecnológicas se interesen por esto. Tienen unas dinámicas y unos recursos que hacen que puedan avanzar mucho más rápido que lo que se hace en el mundo académico", remata Porras.

Primera parada: 1021 cúbits

Hay una diferencia notable entre IBM y Google. Esta última ha sido más reticente a abrir sus sistemas cuánticos más allá de las entidades y centros de investigación con los que se ha asociado con este fin. Sin embargo, el que fuera otrora mayor fabricante mundial de ordenadores y que fue la primera empresa que lanzó la computación cuántica en la nube, ya ha abierto sus creaciones a clientes y tiene acuerdos firmados con multinacionales de la talla de JP Morgan o Exxon Mobile para ser su proveedor. Es cierto que sus equipos comerciales se manejan con muchos menos cúbits —el primero que estrenó, en 2017, tenía 20— pero les sirve como pista de pruebas y para enriquecer su investigación. "Lo que están haciendo estas empresas es prepararse y pensar de qué les puede servir esta tecnología el día de mañana, cuando esté disponible escala y disponible ampliamente", añade.

Cabe puntualizar que no todos los que están en esta lucha cuántica apuestan a esa idea de aglutinar el mayor número posible de cúbits con el fin de que la mayoría enderece y compense los errores de los menos. Microsoft, por ejemplo, está experimentado con una partícula conocida como fermión de Mejorama. El efecto que podría tener en los cúbits sería el de aumentar su dureza y resistencia a las inclemencias del entorno.

En 2023 se podría ver el primer ordenador con 1.000 cúbits, primer gran hito

IBM al igual que Google también utilizó recientemente la expresión "punto de inflexión". En su caso lo hizo para referirse a un golpe de pedal que se producirá, si nada falla, en 2023. Ese es el año previsto para que Cóndor, un procesador de 1021 cúbits, levante el vuelo. "Lo importante es que hemos dado fecha y cifras sobre cúbits, pero, además, lo hacemos hablando de cúbits de calidad que no produzcan demasiado ruido en los resultados", Carmen Recio, científica de IBM Research en Zúrich.

Existe cierto consenso en que, una vez se superan esas cuatro cifras, se puede empezar a tener señales certeras de que estas computadoras pueden ser más eficientes y rentables que el de la actual generación de supercomputadoras. "Ese logro va a sentar las bases para ese objetivo a largo plazo de construir ese ordenador cuántico universal con tolerancia a errores". Explica Recio que IBM ahora utiliza un 'código' creado 'ad hoc' para subsanar estos fallos, pero que, a día de hoy, en la computación cuántica no se ha conseguido dar con la fórmula exacta para ello.

System One Q, el primer ordenador cuántico comercial de la historia. (IBM)

En medio de esta carrera, tan abstracta como difícil de comprender para el común de los mortales, aparece un concepto clave: la supremacía cuántica. Se habla de que los ordenadores que funcionen con cúbits pueden ayudar a crear baterías más eficientes, fertilizantes más eficaces, entrenar mejor que nunca las inteligencias artificiales o incluso ayudar a preceder mejor todavía los mercados financieros mundiales. La ventaja quedará demostrada en el momento en el que un ordenador de este tipo supere a los actuales ante un reto concreto y bien definido. "Esa es la gran cuestión, ¿qué diseñamos o inventamos para demostrar que supera a lo que ya tenemos? En ese momento se sabrá para qué utilizarlo", comenta Contreras Tejada. "El problema es que eso ha sido indemostrable a día de hoy. Lo que puedes hacer es dar evidencias de que es así, pero no lo has demostrado".

Google e IBM se enfrentaron en su momento por este concepto. El buscador afirmó en 2019 que un ordenador de su creación era capaz con 53 cúbits de resolver un problema en 200 segundos que a Summit, un 'superordenador' que su rival creó para el Departamento de Energía de EEUU, le hubiese llevado 10.000 años completar. IBM no tardó en responder y corregir esta cifra: su máquina era capaz de hacerlo en 2,5 días.

¿Realmente para esa diferencia de tiempos merece la pena el esfuerzo e inversión de miles de millones que hay que acometer? Para esta empresa, con estos datos en la mano, la respuesta es clara: esa superioridad cuántica no está demostrada 100%. También cabe mencionar que el experimento que apoyó la afirmación del grupo de trabajo de Google era algo diseñado 'ad hoc' con ese fin.

Faltan algoritmos

"Es una pregunta que no se suele hacer con tanta crudeza, porque se ha avanzado mucho en la parte de 'hardware'. Pero es momento de que las empresas, los investigadores y los involucrados hagan ese trabajo de qué problemas hay y sobre todo en cuáles merecerá la pena utilizar computación cuántica con ese fin", añade Diego Porras.

El problema a la hora de preguntarse los problemas concretos que van a solucionar es que faltan algoritmos. A pesar de las promesas de ser exponencialmente más rápidos, los investigadores aún manejan poquísimos desarrollos que se puedan utilizar en un ordenador cuántico. Es más, se tiende a utilizar entornos de simulación en superordenadores tradicionales que emulan la informática cuántica y no estos equipos.

Una de las cosas que hizo IBM para avanzar en esta dirección es habilitar una plataforma abierta donde colaboran con múltiples organismos de todo el mundo (en España, por ejemplo, participa el CSIC y la Universidad Autónoma de Madrid) para identificar esos primeros usos comerciales concretos que se le pueden dar.

Foto: EFE.

"Queda por descubrir, pero se han identificado potenciales áreas de actuación como el área de las finanzas o la química", añade Recio. "Ahora se está produciendo una investigación muy grande en algoritmos cuánticos como dónde se pueden aplicar. Cuando se logre, hay que tener en cuenta un solo algoritmo se puede aplicar en varios campos", explica esta experta. "Puedes identificar el problema, pero no es inmediato saber cómo se aplica la computación cuántica, sino que también hay que trabajar cómo se representa el problema para poder aplicar dicho algoritmo en casos de uso reales".

Aunque todavía no haya muchos algoritmos concebidos para utilizar esta fuerza, ya hay algunos indicios de lo que se podría lograr. Una de las tareas sería la factorización de números primos, lo que podría suponer "la ruptura de los códigos criptográficos" que ahora mismo sustentan la seguridad y el cifrado en internet. "Para alcanzarlo, probablemente haga falta un ordenador mejor incluso que el que propone Google", apunta Porras.

"La factorización en números primos de números muy grandes era una tarea que un ordenador normal tardaría miles de años y por eso la criptografía es segura", comenta Recio a este respecto. "Bajo esas hipótesis de equipos con millones de cúbits con tolerancia a errores, que todavía no se producen, se reduciría el tiempo exponencialmente. Eso es un peligro y efectivamente a tenerlo en cuenta, pero ya se están desarrollando nuevas técnicas que no se pueden romper con computación cuántica".

Por

Michael Mcloughlin

21/05/2021 - 12:56 Actualizado: 21/05/2021 - 16:38

Google tiene fecha para 'vender' su ordenador cuántico, pero aún no sabemos para qué usarlo (elconfidencial.com)